В ходе работ по продвижению сайта появляется необходимость закрытие от поисковых систем ряда страниц, которые не несут полезной информации для пользователей, мешают корректной индексации и ранжированию сайта или могут содержать данные, попадание которых в открытый доступ необходимо избежать. Появляется необходимость самостоятельно показать поисковым системам, какие части сайта не следует индексировать и размещать поиске. Подобные инструкции прописываются в специальном файле на сайте – robots.txt.

Robots.txt – специальный текстовый файл, расположенный в корневом каталоге сайта и содержащий инструкции для поисковых систем. В файле robots.txt можно указать информацию как для каждой поисковой системы в отдельности, так и для всех поисковиков сразу.

Как создать robots.txt?

Файл robots.txt легко создать при помощи любого текстового редактора, например Блокнот. Для этого достаточно создать новый файл с именем «robots.txt», и заполнить его всеми необходимыми директивами. После того, как файл создан, его необходимо поместить в корневой каталог вашего сайта.

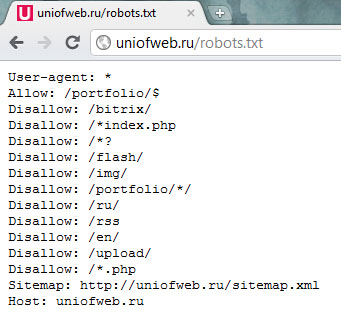

Пример размещения готового сайта robots.txt:

Основные директивы robots.txt

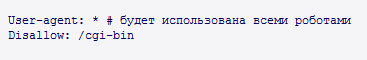

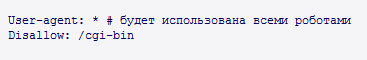

User-agent – директива, где указываются наименования поисковых роботов, к которым будут применяться написанные ниже правила. Для того чтобы написанные инструкции использовали все роботы, поддерживающие robots.txt , достаточно указать в директиве User-agent значение «*»:

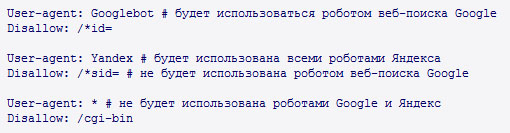

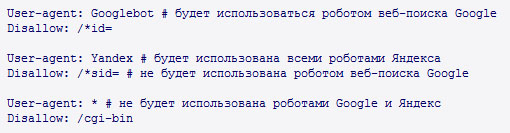

Если написанные директивы предназначаются определенным поисковым роботам, то в User-agent пишут их названия:

Информацию по поисковым роботам Google можно получить

тут, по поисковым роботам Яндекса

тут.

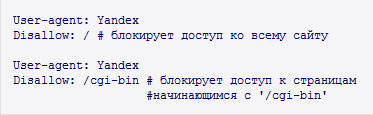

Disallow – директива, позволяющая запретить доступ роботов поисковых систем к конкретным страницам и разделам сайта. Директиву Disallow используют для того, чтобы скрыть страницы или разделы, которые не имеют информационной значимости для пользователей (технический разделы сайта, дублирующийся контент и т.п.). Также данная директива позволяет закрыть информацию, которая не должна попасть в общий доступ (личные данный пользователей и т.д.):

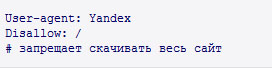

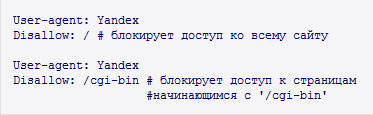

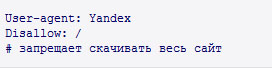

При помощи директивы Disallow можно запретить доступ поисковых роботов ко всему сайту целиком:

При запрете индексации всего сайта – она полностью пропадает из поиска.

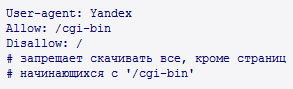

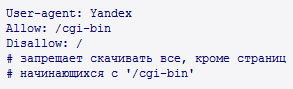

Allow – директива, которая позволяет разрешить доступ поискового робота к странице или разделам сайта. Часто данная директива используется, когда надо открыть для роботов небольшое количество страниц раздела, который планируется закрыть при помощи директивы Disallow:

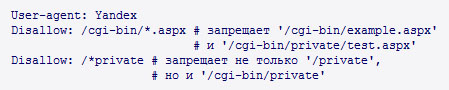

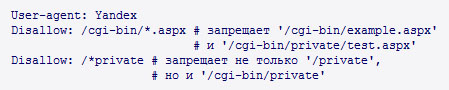

Спецсимвол "*" – обозначает любую последовательность символов. Применяется, если необходимо закрыть (открыть) большое количество страниц с общим набором некоторых символов:

По умолчанию любое правило в robots.txt заканчивается «*».

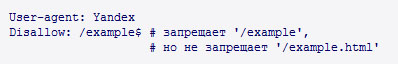

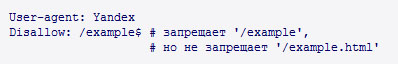

Спецсимвол "$" – используется для того, чтобы отменить использование спецсимвола «*» в конце правила:

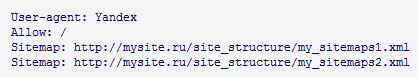

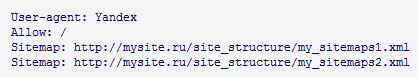

Sitemap

Sitemap – директива необходимая, если для улучшения индексации сайта используется

файл sitemap.xml. При помощи директивы Sitemap можно указать путь к месту расположения одной или нескольких xml-карт сайта:

В дальнейшем, данные из sitemap.xml будут использоваться для индексации сайта.

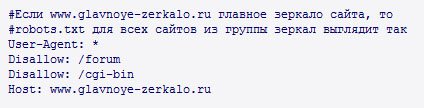

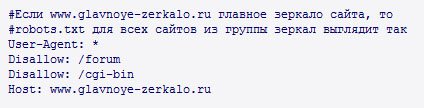

Host – директива, используемая для указания главного зеркала сайта. Если у сайта есть несколько зеркал, то они будут объединены в специальную группу. В таком случае в поиске будет выдаваться только адрес главного зеркала. Для того чтобы у робота-зеркальщика Яндекса не было проблем с определением главного сайта, необходимо указать его в директиве Host файла robots.txt каждого сайта-зеркала:

Директива Host в файле robots.txt указывается после директив Allow и Disallow

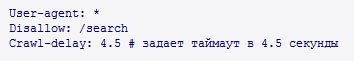

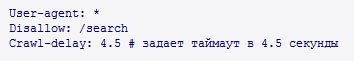

Crawl-delay – директива, которая позволяет указать поисковым роботам минимальное время (в секундах) между скачиванием страниц. Данную директиву следует использовать в случае сильной нагрузки на сервер:

Директива Crawl-delay в файле robots.txt пишется после директив Allow и Disallow.

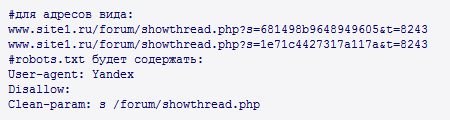

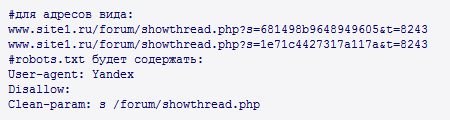

Clean-param – директива позволяющая избежать многократной закачки дублирующихся страниц, возникших из-за не изменяющих содержание динамических параметров. Использование директивы Clean-param снижает нагрузку на сервер, а также позволяет избавиться от одной из основных технических проблем, мешающих успешному

продвижению сайтов в Яндексе – внутренних дублей страниц:

Наиболее частое применение данная директива получила при наличии на сайте идентификаторов сессий.

Анализатор файла robots.txt

Небольшая опечатка в файле robots.txt может привезти к исчезновению из индекса поисковых систем важных для пользователя разделов. Для того чтобы избежать этого рекомендуется использовать специальный сервис, позволяющий убедится, что robots.txt создан правильно.

Воспользоваться анализатором robots.txt можно

здесь.

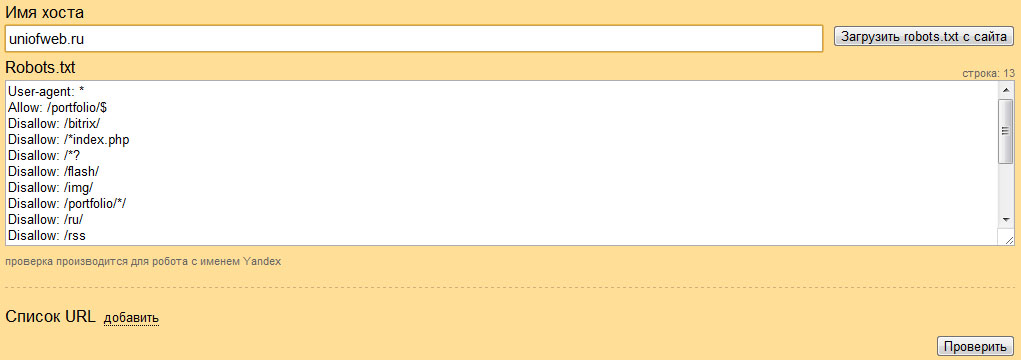

Для того чтобы проанализировать правильность составление файла robots.txt, необходимо в поле «Имя хоста» написать домен сайта, а в поле «Robots.txt» перенести данные из созданного файла. Если файл robots.txt уже загружен на хостинг, то достаточно нажать кнопку «Загрузить robots.txt с сайта» и данные появятся автоматически:

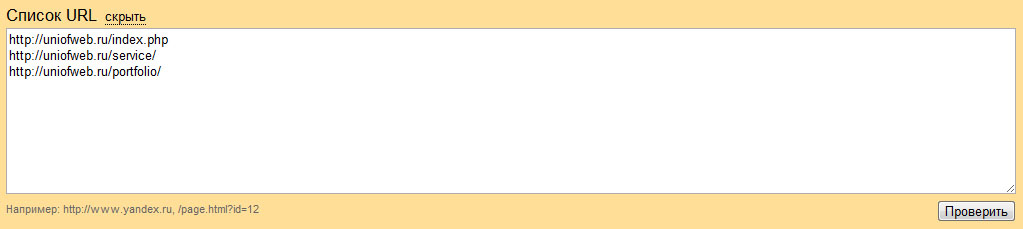

Теперь, чтобы проверить правильность составления файла robots.txt, необходимо сделать проверку наиболее важных страниц (разделов) сайта, которые должны быть открыты, а также добавить для проверки страницы, которые необходимо закрыть. Нажимаем кнопку «добавить» и копируем список проверяемых адресов (допускается использовать как абсолютные, так и относительные адреса страниц):

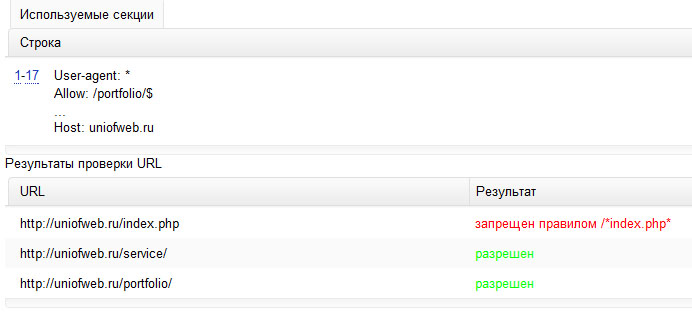

Как только все необходимые адреса внесены в поле ввода, жмем кнопку «Проверить»:

Если все предназначенные для закрытия адреса запрещены к индексации, а полезные разделы и страницы – разрешены, то файл robots.txt составлен без ошибок. Если разделы сайта оказались некорректно закрыты (открыты), то необходимо просмотреть файл robots.txt на наличие ошибок, либо добавить соответствующие директивы Disallow (Allow).

Файл robots.txt можно загружать на сайт (или обновлять информацию в существующем) только после того, как анализатор подтвердил правильность его составления: что должно быть закрыто – запрещено, что должно быть открыто – разрешено.